Data: 19/10/21

Veículo: GoAd Media

A hiperconectividade e o avanço da Internet das Coisas (IoT) e da Internet das Pessoas (YoT) caminham, necessariamente, junto com reflexões e iniciativas que promovam o uso ético da inteligência artificial (AI). O tema foi onipresente nos principais festivais de criatividade, marketing e inovação deste ano, a exemplo do SXSW, do Cannes Lions e do DMexco. E precisa estar no topo das prioridades do marketing em 2022.

Essa preocupação passa pela transparência com relação à coleta e uso de dados e pela forma como produtos e serviços envolvendo AI são idealizados e desenvolvidos. Muitas vezes, esses processos acabam partindo de preconceitos ainda fortemente enraizados na sociedade, como racismo, misoginia e homofobia.

“É quase ultrajante que, para se tornar um médico, você precise fazer aulas de ética médica, mas se você é um programador, não precisa de nenhuma aula de ética, mesmo que sejam os programadores que estejam definindo diversos formatos para a sociedade inteira”, afirmou o filosófo e historiador Yuval Harari durante o SXSW 2021. “Deveríamos fazer com que todos os programadores do Vale do Silício tivessem cursos obrigatórios de ética”, reforçou.

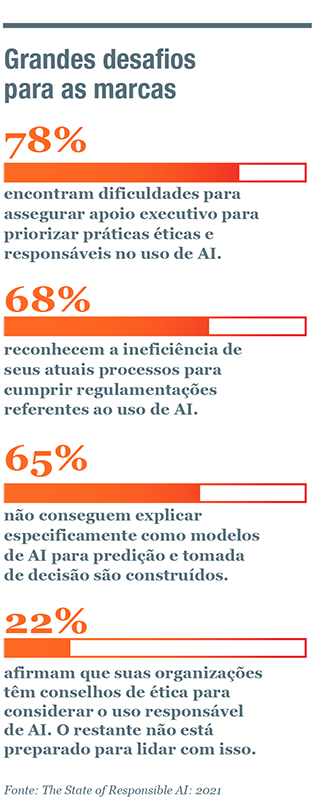

Entre as organizações consultadas para a pesquisa global The State of Responsible AI: 2021, da Fico, 65% não conseguiram explicar como seus modelos de predição e decisão orientados por AI são construídos e 41% admitiram que as companhias em que trabalham não contam com frameworks mais completos e abrangentes para uso ético da inteligência artificial. Foram ouvidos 100 líderes do C-Level com atuação ligada a AI, a exemplo de Chief Data Officers e Chief Analytics Officers (confira, a seguir, mais alguns resultdos da pesquisa).

Mais dados, mais responsabilidades

Conhecimento sobre o tema e responsabilidade para lidar de forma ética com a inteligência artificial é algo que se torna ainda mais urgente para as marcas quando se considera o acelerado avanço de tecnologias como a Internet das Coisas (IoT), nos mais diversos aspectos de nossas vidas, por meio da popularização de wearables e dispositivos conectados em geral.

O estudo Making the Metaverse, elaborado pela Media.Monks, chama atenção para o fato de que uma experiência de 20 minutos com um headset de VR pode gerar cerca de 2 milhões de registros únicos de linguagem corporal, sem falar nos dados captados no ambiente em que a pessoa se encontra.

Isso representa grandes oportunidades de personalizar serviços e tornar as relações com os clientes mais relevantes, mas também aumenta exponencialmente o cuidado que as marcas precisam ter com a forma como capturam e processam essas informações.

Essa questão ganha ainda mais importância quando se observa que, num futuro próximo, o comum será o próprio corpo atuar diretamente como interface conectada, por meio das Internet das Pessoas (Yot). Tecnologias neurais pouco invasivas, usando fitas adesivas ou toucas, já prometem “ler” nossos pensamentos por meio do reconhecimento de nossas ondas cerebrais. A previsão é de que nem mesmo esse tipo de intermediário seja necessário.

Internet das Pessoas

Next Mind é um sistema que permite a leitura de ondas cerebrais e o controle da internet sem fio por meio do pensamento, a partir de um equipamento acoplado à cabeça. Ao transformar nossos corpos na própria web, a You of Things aumenta possibilidades de coleta de dados e desafia marcas com relação à privacidade das pessoas.

Inclusão x vigilância

Também considerando uma abordagem ética, uma vertente que pode e deve ser explorada no uso de AI é sua capacidade de promover a inclusão. Pessoas neuroatípicas podem se beneficiar de tecnologias de reconhecimento de emoções (conhecidas pela expressão Emotion AI), de forma a se apoiar em plataformas para “complementarem” suas limitações pessoais. Para autistas, ter um software que reconheça e identifique as reações e expressões de seus interlocutores pode tornar a interação social menos desgastante.

Mas a mesma Emotion AI pode ser empregada de forma negativa e exacerbar a vigilância sobre as pessoas. No ambiente de trabalho, por exemplo, essas ferramentas podem ser usadas para monitorar a concentração durante o expediente e em outros procedimentos que desrespeitam a privacidade das pessoas.

Ampliando as referências da AI

Por meio do Project Understood, pessoas com Síndrome de Down se tornam professoras do Google, “doando” sua voz para treinar os modelos de reconhecimento de voz da empresa e ampliar o “repertório” da AI. A iniciativa foi premiada na última edição do Cannes Lions.

A necessidade de regulação

A futurista Amy Webb, fundadora do Future Today Institute, é uma das profissionais que alerta para o perigo de explorar tecnologias emergentes sem estabelecer modelos de regulação mais eficazes. Com a crescente integração entre humano e tecnologia, Webb acredita que é latente a necessidade de repensar o papel das nossas instituições e legislações, já que suas balizas não estão se modernizando na mesma velocidade dos avanços tecnológicos.

“Até agora, são as empresas privadas que estão exercendo esse poder [de regulamentar os usos das tecnologias], e não outras instituições. Os legisladores precisam aparecer. Não podem ignorar ideias politicamente impopulares até que exista uma crise. Precisam estar dispostos a investir no longo prazo”, enfatizou a futurista em sua apresentação no SXSW 2021.

Ferramenta ajuda a modificar humor

The Mood Modifier é um aplicativo que deteca a emoção das pessoas em determinado momento, a partir de tecnologia de reconhecimento facial,e seleciona músicas personalizadas de acordo com o estado espírito naquele momento – ajudando, por exemplo, a minimizar a tristeza e o estresse por meio da música. Consentimento e transparência sobre o uso dos dados compartilhados são essenciais em projetos como esse.

Mais poder para os clientes

Um dos casos mais comuns de uso antiético da inteligência artificial, atualmente, é a forma como as corporações acessam os dados das pessoas e lucram com isso ainda de forma pouco transparente e, na maioria das vezes, injusta com os usuários – boa parte deles nem entende como suas informações são compartilhadas e muito menos recebe algo em troca.

Nesse contexto, a Lei Geral de Proteção de Dados (LGPD) busca garantir mais segurança e informação para os clientes das marcas. E alguns empreendedores vêm procurando dar mais poder às pessoas, inclusive financeiro, sobre o uso de seus dados. É o caso da Streamlytics, que desenvolveu um algoritmo para monitorar o comportamento de clientes de serviços de streaming e estabeleceu um valor para esses dados, oferecendo aos usuários a possibilidade de comercializá-los de forma anônima. A startup se encarrega da intermediação com as empresas que compram as informações e do pagamento aos usuários.